Sommaire

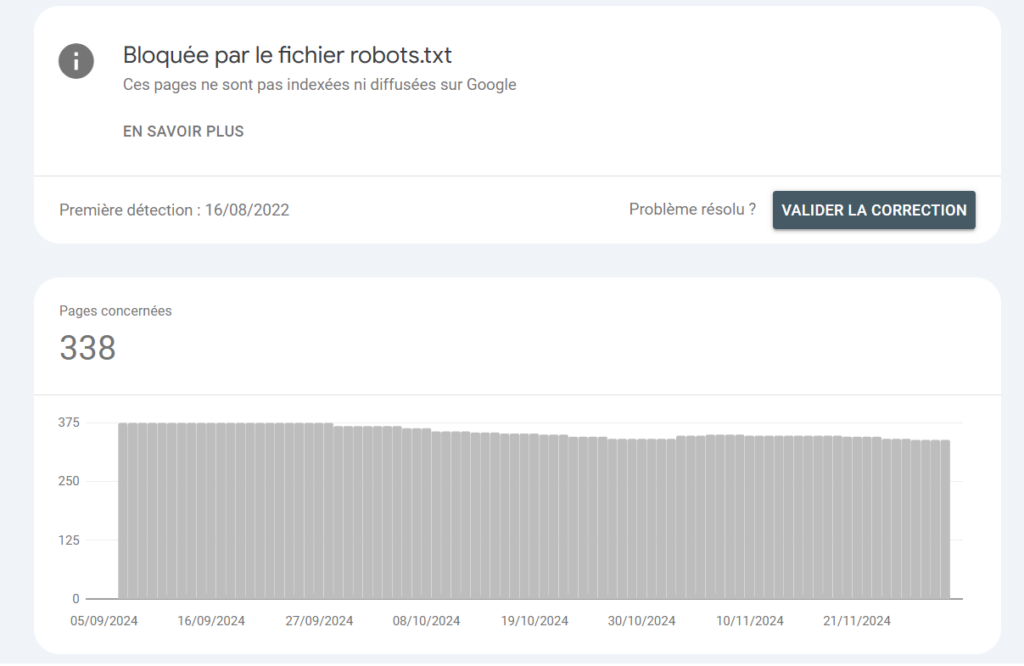

Dans Index (Google Search Console), la fonctionnalité Pages vous apporte un grand nombre d’informations sur les pages exclues de l’index, et vous liste les motifs qui justifient cette exclusion. Parmi les éléments remontés, vous pouvez trouver la ligne bloquée par le fichier robots.txt

Pourquoi bloquer une URL avec le fichier robots.txt ?

Un fichier robots.txt est un fichier au format texte (.txt) placé à la racine de votre site ou à la racine d’un répertoire.

Le fichier robots.txt permet de gérer le comportement des robots d’exploration des moteurs de recherche sur votre site, en limitant leur capacité d’exploration.

Vous pouvez gérer deux types d’information :

- User-agent: définit le robot d’exploration concerné (par défaut, une étoile * permet de s’adresser à tous les robots).

- Disallow: permet de ne pas autoriser l’exploration d’une URL ou d’un groupe d’URL.

Par exemple, les instructions suivantes permettent d’interdire à tous les robots l’exploration d’une URL précise :

User-agent: *

Disallow: /page-a.htmlVous pouvez également bloquer des répertoires entiers ou des séquences de caractères avec un fichier robots.txt :

User-agent: *

Disallow: *cacahuete*

Le blocage d’une URL ou d’un groupe d’URL est utile dans des biens cas pour votre SEO. Vous évitez par exemple d’égarer les bots vers des pages qui n’ont pas vocation à ressortir sur les moteurs de recherche :

- pages sans contenu

- URL avec paramètres (qui finissent par exemple par ?source=abc)

- pages générées lors de recherches internes

- etc.

Une indexation possible malgré un blocage par robots.txt

Le fichier robots.txt limite les capacités d’exploration de Googlebot (ou d’autres robots d’exploration). Mais l’algorithme de Google peut décider d’indexer tout de même une URL dont vous n’autorisez par l’exploration via le fichier robots.txt. Seule une balise <meta name=”robots” content=”noindex”> peut remplir ce rôle !

Pourquoi Google Search Console remonte une liste d’URL bloquées par le fichier robots.txt ?

Le rapport Indexation des pages > Bloquée par le fichier robots.txt vous communique une liste d’URL auxquelles Google n’a pas accès car vous avez demandé leur blocage avec le fichier robots.txt

Je vous invite à vérifier régulièrement les informations présentes dans ce rapport pour vous assurer que seules les URL dont vous voulez réellement interdire l’exploration (et de facto l’indexation) sont citées dans cette liste.

Si c’est le cas, vous n’avez aucun souci à vous faire. Si des URL destinées à être positionnées s’invitent dans ce rapport, vous devez agir avant de constater des conséquences potentiellement lourdes pour votre référencement naturel.

Comment corriger un souci d’URL bloquées par le fichier robots.txt ?

Je vous invite dans un premier temps à ouvrir votre fichier robots.txt. Pour rappel, il est à la racine de votre site web ou de votre sous-domaine.

Vérifiez qu’aucune directive ne vienne interdire l’exploration de la page. Si vous avez par exemple une directive du type Disallow: *arc*, toutes les URL qui ont cette séquence de caractères seront bloquées. C’est vraiment la première action à réaliser, et cela peut vous éviter bien des déboires.

Si vous ne comprenez toujours pas d’où vient le souci, vous devez pousser vos investigations :

- Prenez l’URL qui pose problème et passez-la dans l’outil Inspection de l’URL et voyez le message obtenu.

- Utilisez un outil de test de redirections tel que https://www.redirection-web.net/. J’ai déjà vu un souci de redirection à un slash de fin d’URL près. Si l’internaute saisissait l’URL avec un slash en plus à la fin, il était redirigé vers une URL qui affichait le contenu mais qui n’était pas la bonne et qui était à ce titre bloquée par le fichier robots.txt

Vous ne comprenez toujours pas d’où vient le problème ? Faites appel à un professionnel du SEO ! On a l’habitude de ce genre de situations et on trouvera la solution.